Schauderbasis

Changelog 5

Here is what I worked on since the last changelog.

tried out typst

I tried a new typesetting system: typst It is so awesome.

I love the command line interface. I love how simple it is in comparison with LaTeX. I love that it has a scripting language embedded. And I love that it invites you separate layout from data.

There are lots of interesting templates. But I didn’t find something that suited me well enough, so I just wrote my own. This would be a big undertaking in LaTeX, but in typst I could just learn how to do it on the fly.

My document is not completely done yet, but it is mainly a question of content at this point. I will definitely use typst again, especially when creating documents programmaticly.

Reactivated the Scraper

2 years ago I wrote a webscraper and automated it to run once a day. The program …

- scrapes all the job offers on a special website

- transforms them from html to org-mode

- saves the resulting files into a git repository

I managed to implement all this into a gitlab CI job.

Also the repo of the scraper is the very repo where the data ends up, which I find elegant.

Even more elegant:

This means that the CI job creates a new commit on it’s own repository.

It wasn’t even that hard, here is the .gitlab-ci.yml:

image: python

stages:

- collect_data

- commit_and_push

collect_data:

stage: collect_data

before_script:

- pip install -r requirements.txt

script:

- python scrape.py

- find scraped_data | sort # show off what we created

artifacts:

paths:

- scraped_data

expire_in: 1 week

# Take the artifacts from the previous job and commit them as new data.

commit_and_push:

stage: commit_and_push

only:

- schedules

script:

- git checkout data # make sure to use the right branch

- rm -rf data # remove current data

- rm -rf scraped_data/html # remove stuff I don't want in the repo

- mv scraped_data data # put the new data in place

- git add --no-ignore-removal data # put all the changes in data on the index

- git -c user.email="$GITLAB_USER_EMAIL" -c user.name="$GITLAB_USER_NAME" commit --allow-empty --message="Added data_from $(date +%FT%T)"

- git push "https://gitlab-ci-token:$GITLAB_PUSH_TOKEN@gitlab.com/$CI_PROJECT_PATH.git" "HEAD:$CI_COMMIT_BRANCH"

The result of running this regularly is a versioned plain text job offerings. This is awesome if you are interested in questions like:

- What offerings contain the word a certain word (like

pythonorarchitect)? (just usegrep/git grep/ripgrep) - How long has an offering been online yet? (just use

git log) - How many offerings are added/removed from the website in a certain time frame? (just use

git diff --stat) - Do offerings change after their initial posting? (

git logagain)

I find this insights fascinating. Especially because the website itself answers none of this questions, yet scraping it over some time provides the answers seemlessly.

…unless the pipeline breaks that is. I had not cared to fix the CI for some time. But now I did and the fix was pretty trivial.

Improved my desktop

I had some time to improve my desktop.

- Use a new nerdy greeter: tuigreet on greetd

- implement a workflow where I can edit screenshots right after taking them. I am still looking for a great tool to edit screenshots with. Perhaps the incoming gimp 3? But gimp has no good arrow-support :(

- allow mouse scrolling in tmux

- use more features of waybar

- add a shortcut to switch keyboard layouts

Changelog 4

I like the concept of those changelog posts. It makes me feel less pressure to write a full story and add pictures or so. It also gives me a better sense of progress.

I noticed that this post is longer then the older ones though. That is something I need to keep an eye on.

I am also not sure about the fact that almost every sentence contains the word “I”. It is a consequence of the forat of course. Every sentence is about something I wanted, decided, tried or did.

Enough of this, here is what I did since the last changelog.

merged my home-manager config into my NixOs config

I used to have separate repos for my home-manager config and my NixOs config. This was useful once when I was using macOs regularly. But I haven’t touched a mac in years, so the split wasn’t helping me anymore. On the other hand it meant that I needed to set up multiple repositories for every new computer. So I decided to merge them.

This was a lot more involved then I thought. Merging 2 git repositories with unrelated histories is surprisingly hard. Especially since I wanted one repo to be in a subdirectory of the other one.

I recently wrote an article about how git filter-branch wants you not to use it. But filter-branch is exactly what you would normally use for such a task, where the history of a repo is heavily edited. Fortunately there is an external software-project, git-filter-repo that is much cleaner and better documented.

I finally managed to do it with git filter-repo --to-subdirectory-filter and then git merge --allow-unrelated-histories.

A lot of backups were created that day. Changing history is about as easy as scify movies make it sound.

set up a Jellyfin instance on the server

I finally have a need for a media center: The kids want to consume the same media again and again (as kids do). I need an easy way for all family members to consume that media with the them.

After having had an eye on kodi and plex for quite some time I decided that I’d rather try out Jellyfin.

Jellyfin is really cool. (Once it is running) it looks quite nice. It fetches tons of metadata from imdb or tmdb. And it forces you to keep your media files in an orderly structure.

Once again, figuring out how to do anything on NixOs was hard. But I am getting better at it, especially since I am slowly getting the hang of nginx. Also reading nix code is getting easier and easier. So it didn’t take too long to get it running.

The hardest thing was finding out why I couldn’t connect to the server. It was set up, I could read it’s logs and all, but I just couldn’t connect to the Jellyfin server. I rubberducked it to Sandra and to my astonishment she gave me the answer right away: “Perhaps you need a restart, or it is the firewall or so?” She is not a very technical person, so this was awesome advice. I had forgotten to open the right ports…

This is what workes for me:

{ lib, config, ... }:

let

jellyfinPort = 8096;

jellyfinUrl = "MY_URL_FOR_JELLYFIN";

in

{

services.jellyfin = {

enable = true;

};

services.nginx = {

enable = true;

recommendedGzipSettings = true;

recommendedOptimisation = true;

recommendedProxySettings = true;

recommendedTlsSettings = true;

virtualHosts."${jellyfinUrl}" = {

enableACME = false;

forceSSL = false;

locations."/".proxyPass = "http://localhost:${toString jellyfinPort}";

locations."/".proxyWebsockets = true;

};

};

security.acme = {

acceptTerms = true;

certs."${jellyfinUrl}".email = "MY_MAILADDRESS";

};

networking.firewall.allowedTCPPorts = [

80 443

];

networking.firewall.interfaces.wiregrill = {

allowedTCPPorts = [ jellyfinPort ];

};

}

set up Jellyfin again, but on a local server

I later decided that I wanted to have my media server at home rather then on the internet. So I set up my old raspberry pie 4 and installed NixOs on it. My NixOs config is nice and modular, so I could just enable the module from above and everything worked just as on my server. No problem at all.

I love that so much about NixOs.

used mkOption for the first time

I finally found that it was time to add my own options into my NixOS config. The documentation is fine here and there are plenty examples around.

I need this because the config for backups is almost but not quite identical on my machines. For example the paths of the directories that I want to back up vary. So now I can write one general module that defines some options and every machine sets this option to it’s own value.

Ideally every machine would only specify the following:

backup = {

enable = true;

paths = [

"/home/johannes/SecretPlans/"

"/home/johannes/PublicPlans/"

];

};

The rest (“Where is the backup server?”, “How often should backups be done?”, “How should they be encrypted?”) is defined in the backup-module. That is also a good place to write down some documentation.

This feels very clean to me.

I still didn’t do monitoring of my backups. This is dearly needed though. I don’t want to find out I haven’t done backups for months.

Changelog 3

Addressbook visualization came to a halt

Previously I had tried to visualize my address book as a graph. I stopped when I noticed that the vcf export I had didn’t include the photos. This was a problem of the address book app I use on my phone, so I filed a bug report. This stopped my momentum to work on the project for the moment.

Now that the Simple Mobile Tools have been sold and are likely to go in a different direction I will probably have to replace most of my mobile apps anyway, though.

Work on video streaming solution

I installed Jellyfin (a video streaming) solution on my server. It was reasonably easy (thanks to NixOS), but I soon noticed that I don’t have enough storage space on my server to store all the movies and shows I want. I monitored the Netcup Adventskalender for cheap storage upgrades, but the right thing for me was not in there.

So I will have to buy for the regular price soon. It is not really expensive, so that is fine. After that I will be able to continue the work on Jellyfin.

Backup Sandra’s laptop

The one PC in our home that doesn’t run NixOS is Sandra’s laptop. On NixOS automatic backups are just a question of a few lines of config of course. But on Fedora I had to do everything by hand, including a systemd unit for triggering the backup. I used a guide of course.

The biggest problem I had after that was the initial backup, which took so long that it failed for some reason. The Laptop is a very weak one and I guess it was just too much for it.

So I started out with excluding the big directories (Music and Images) from the backup. Then, when the backup was successful I reincluded them gradually, so only a few GB of data had to be added to backups.

If this had been a work project I would have had to think of something better, but for a private project doing this by hand was fine.

And now we know to have working backups of all machines again, yea!

Monitoring

Wouldn’t it be nice if you got an email if there has not been a backup created for a few days? Now that the backups run I would like to monitor them. It is time to have monitoring.

But boy this stuff is complicated. Especially if you want to have it set up in a reproducible and documented way.

Zabbix didn’t work for me, so I looked into Graphana.

Graphana is cool in combination with Prometheus and Telegraf. At some point I also had Loki, Promtail and InfluxDB running. It is nice to see how well everything works together, but I found it very hard to understand what I need. Especially because I don’t even know what I want.

It would probably be easier if I had a working setup to learn from.

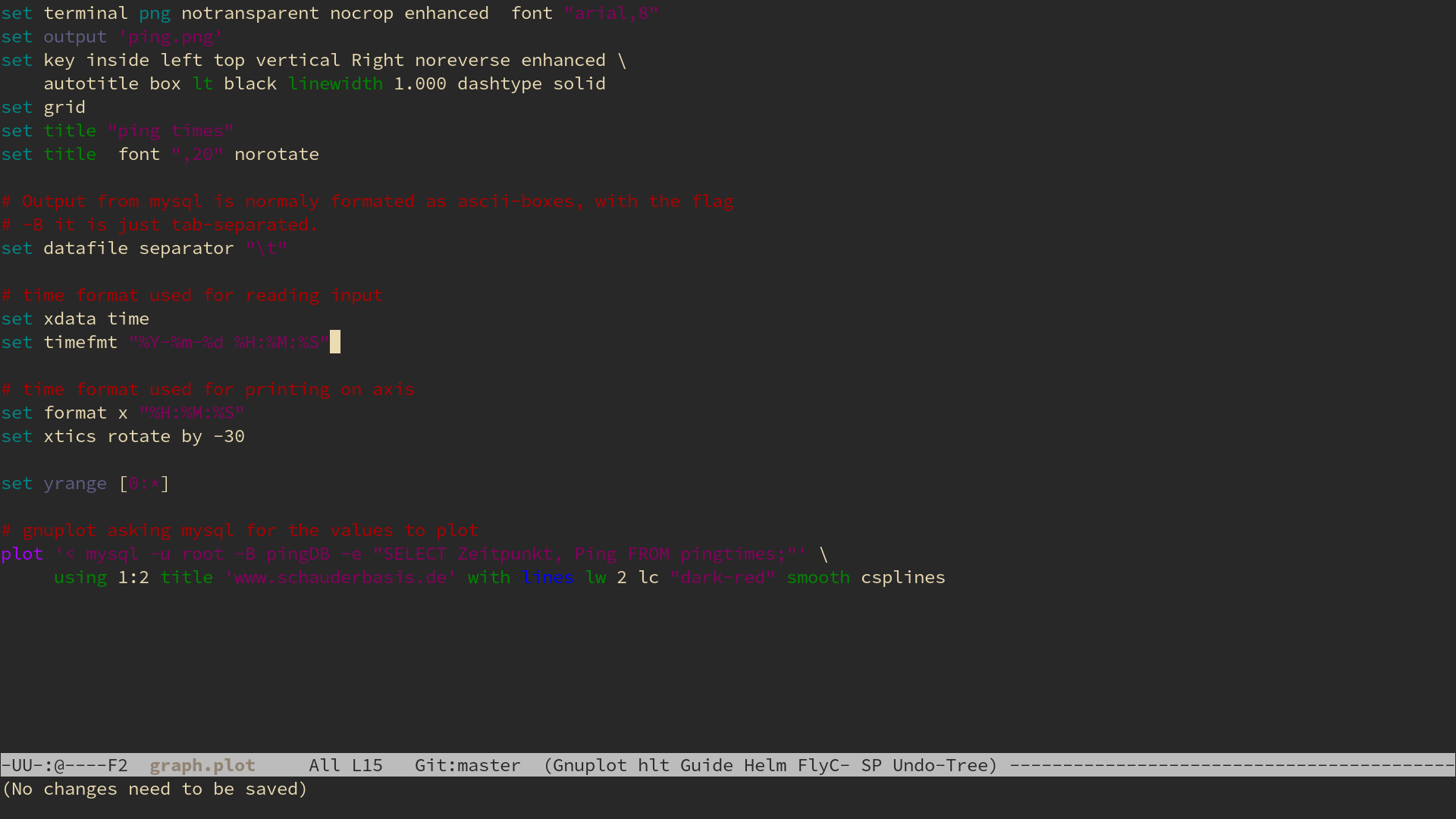

In the end I ended up with a selfmade dashboard that monitors my website (schauderbasis.de). That is fine for now, I will try to expand on this at some point.

IOPCC

I found out I had won the IOPCC. I was very proud and tried to explain the achievement to a few non-technical people. All of them were very supporting, but it was clear that I had not been able to get across the point of the contest.

So I wrote a blogpost about it.

Nixos channel update

I noticed that my Laptops Nixos is running on an old channel, so I updated it to the latest stable channel (from 22.11 to 23.11).

I used this guide to upgrade because I don’t do this very often. It went uneventful. Some config parameters had to be renamed and some software had to be replaced because it was not supported anymore (exa -> eza).

I took the opportunity to run nix-store --gc, for the first time in about a year.

Many GB of storage were freed.

But perhaps I shouldn’t have done it:

When I recompiled my system it took nearly an hour (instead of less than a minute, like normally).

I think a big chunk of that is building emacs from master.

Worth it, though.

winner of the first IOPCC

I am a big fan of the “The International Obfuscated C Code Contest” (IOCCC). Their winners page is littered with creative and (in it’s own way) elegant code. Unfortunately I know just enough C to appreciate the code there, I could never write anything like this myself.

So I was on fire when I heard that there was a python-version of the contest: The IOPCC. I immediately started to work on a submission.

It was a lot of fun on multiple levels. I had wanted to do something with abstract syntax trees for a long time, so I started fooling around with them until I had something sufficiently obscure. Then I started to condense it, make it as obscure as I could and formed it into an ascii art image.

When I was satisfied I submitted the code and waited.

What I submitted

Normally code I write would go into a repo, but this is a piece of art, not a piece of work. It won’t be iterated on anymore, there are no pipelines, no issues. So I will just link the files here in this blogpost:

- The code is save to run, but you should not trust my word of course.

- An explanation of what it does and how it does it.

The output of the code looks like this:

The announcement

I waited and waited.

A few months later the winners are announced. And I am one of them! Horray!

Here is what the Judges said about my code:

Most Introspective.

Very well put together, top-notch obfuscation. Tongue-in-cheek, comments on itself (very meta, which we like).

This definitely goes into my resume. If people see this award winning code they probably won’t hire me, but I don’t care. I am very proud.

Changelog 2

git showpast

I wanted to write a command-line program that would show you the history of some code within a git repository.

- When/How/By whom was it written?

- When/How/By whom was it slightly changed?

- When/How/By whom was it moved?

I know git blame, but this is tedious to use and I still haven’t got the hang of it.

I spent some time deciding on which tools I would like to use for this project.

- Python, because it is the best to get something done?

- Haskell, because it is the best to write logic in. This is one of the rare “much logic, little IO”-problems, which is where haskell normally shines.

- Rust, because I want to get better in rust.

I decided to go for rust (and the excellent git2 crate). Rust is so cool to work with, because of the strict compiler. I really enjoy that.

I even started reading the git mailing list a bit. It was very interesting, but not ultimately useful to my course.

The project died very early, though, with very little code to show for it. Other projects got more interesting to me.

music streaming

I finally got navidrome on my server going. It is a self-hosted music streaming service.

I dislike the loss of control that streaming-services like Spotify etc bring with them. But a selfhosted version? I can get behind that.

Navidrome is cool for multiple reasons.

- It only reads my music directory and doesn’t change it (This is the best. I can work with files and navidrome will discover changes and update it’s internal database.)

- There is a web UI, but every subsonic-compatible client will work (there are a lot of those).

- Installation on NixOs is just a few lines in the config. Getting this right is hard (for me) but once it works it is so consistent, dense and elegant.

Next steps:

- move all my music into one central place for navidrome to read

- add metadata to all the files because navidrome doesn’t really care for directories. (mp3info is use useful for that)

- Install clients on all my devices

- Make it available to others in the house

address book analysis

I wanted to do an analysis and visualization of my address book. I wrote a blog post about a mistake I made in that process. There was a cool parser package for python once (vobject) but it’s development has stalled many years ago. So I wrote a basic parser myself and it was actually quite fun.

I am looking forward to continuing with this project.

vcf confusion

The contacts in the address book on your phone can be imported and exported using the vCard format.

This is basically a text file with a .vcf file extention (for virtual contact file).

It is surprisingly readable, here is an example (slightly redacted example from here):

BEGIN:VCARD

VERSION:3.0

N:Doe;John;;;

FN:John Doe

EMAIL;type=INTERNET;type=WORK;type=pref:johnDoe@example.org

TEL;type=WORK;type=pref:+1 617 555 1212

TEL;type=WORK:+1 (617) 555-1234

TEL;type=CELL:+1 781 555 1212

TEL;type=HOME:+1 202 555 1212

NOTE:John Doe has a long and varied history\, being documented on more police files that anyone else. Reports of his death are alas numerous.

CATEGORIES:Work,Test group

END:VCARD

I mean, what is there even to explain? You can just read it. And if anything is unclear (perhaps why the name is there twice) you can just read all about it on the official standard (RFC 6350). And even that one is nice and readable.

What an awesome format.

I want to analyze my address book

I wanted to do some data analysis on my address book

- I knew what I wanted to do with the data and had an idea what the result might look like.

So I exported it into a

.vcf-file and moved it to my computer.

It was tempting to write a parser for it myself. But one of the things I learned over the last years is to not reinvent the wheel. Especially if the alternative is just an import and reading a bit of documentation.

So I looked on pypi and was pleased to find a lot of vcf packages. 445 - perhaps a bit more then you would expect.

I just tried out one or two, but I got a strange error messages.

vcfpy.exceptions.IncorrectVCFFormat: Missing line starting with "#CHROM"

Hmm, that’s right, there is no line starting with #CHROM in my .vcf-file.

Is my export broken?

Is the package outdated perhaps?

So I tried another package, but I kept getting these error messages.

Strange…

What does $CHROM even mean?

Should I just add it to my file if the package wants it so desperately?

I looked up the standard - there wasn’t anything about #CHROM.

I looked up the error message on the internet - there definitely were people talking about #CHROM in their .vcf-files.

I looked up the documentation of the package - no really useful information.

I kept reading and finally found it:

There are multiple file formats named VCF.

There is the one about contacts, but there is also the “Variant Cal Format” used for genome-data in bioinformatics.

No wonder there are so many vcf-packages out there.

And #CHROM stands for chromosomes of course.

I had been reading the wrong documentation all along. Guess I should have just reinvented the wheel.

Wie Anfänger an Einfachem scheitern

“Snakes and ladders” ist ein so einfaches Spiel, dass es fast keine Regeln zu erklären gibt:

“Würfeln, laufen und wer als erstes ins Ziel kommt gewinnt. Wer auf einem markierten Feld landet kommt woanders raus.”

Ich wüsste wirklich nicht was man mehr erklären sollte.

Im eigentlichen Sinn ist es nicht einmal ein Spiel: Es gibt keine Entscheidungen, welche die Spieler treffen können, keine Fähigkeiten werden unter Beweis gestellt - man würfelt und zieht. Es ist mehr wie ein Protokoll, das abgearbeitet wird, um einen zufälligen Sieger zu bestimmen. Kaum mehr als ein verkomplizierter Münzwurf.

Aber wer versucht, es mit einem kleinen Kind zu spielen, der kann sehen wie viel implizites Wissen hier vorausgesetzt wird.

Hier ist eine Reihe von Schwierigkeiten, die ich beim Spielen mit kleinen Kindern hatte. (Um die Situation zu vereinfachen hatten wir auf alle Schlangen verzichtet und das Spielbrett sorgsam aufgebaut.)

- Sie wissen nicht, wer als nächstes dran ist.

- Sie wissen nicht, sie man würfelt.

- Der Würfel ist runter gefallen und unterm Sofa verschwunden.

- Sie wissen nicht, was die Zeichen auf dem Würfel bedeuten.

- Sie wollen lieber mit dem Würfel selbst spielen.

- Sie wissen nicht das jeder Spieler nur eine Spielfigur hat

- … und diese nicht mitten im Spiel mit der eines anderen tauschen darf.

- Sie wissen nicht, wie weit sie laufen dürfen.

- Sie laufen in die falsche Richtung.

- Sie können sich nicht auf das Spiel konzentrieren, nicht mal während sie selbst dran sind.

- Die Spielfiguren sind verrutscht und keiner weiß mehr wo sie waren.

- Sie wissen nicht mehr welches ihre Spielfigur ist.

- Sie wollen nicht warten bis der Vorgänger mit seinem Zug fertig ist.

- Sie wissen nicht, wann das Spiel zu Ende ist.

- Sie wissen sehr genau, wer gewonnen hat.

Ich schreibe das alles voller Respekt. Ich weiß sehr genau was es bedeutet, ein Anfänger zu sein.

Das ist einer der Gründe, warum gute Dokumentation zu schreiben unglaublich ist: Es ist sooo schwierig vorherzusagen, wie viel der Leser schon weiß.

changelog

I do a lot of personal computerstuff over the weeks. Most of it ends up in a repository of some sort (if it is not in a repo, have you even done something?) A few things end up in a database, which is fine, too.

But I don’t write about most of it. Apart from the git log there is no changelog, no releases (everything is released immediately) and no Retro.

Thats mostly OK. Most stuff I do is small and not aimed at the public (even when I do it in the open, almost all of my code is on gitlab). So if I do a commit or two every month there is not much to tell.

But wouldn’t it be nice to have some document of accomplishment every once in a while? An opportunity for retrospection? Lets try that.

So here is what I did in these days:

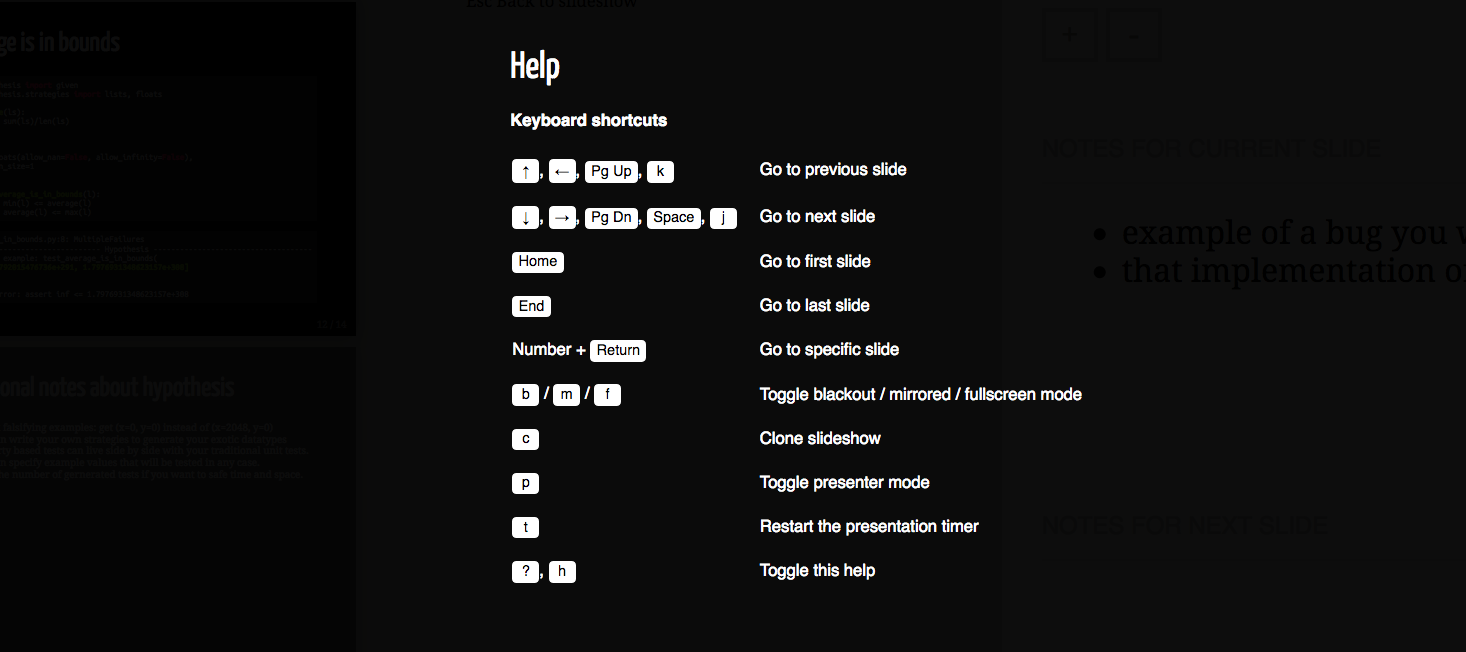

talks

In the last weeks I have written a website for the talks I have held. It was only the second site that I wrote completely from scratch. I am quite proud of it.

I used hugo as a site generator, but wrote the theme completely myself. I had an easier time figuring out the hugo templates, the HTML and the css. MDN is a really good resource.

The most difficult part was getting the css work for both mobile and desktop.

This was a big project for me.

There is still a lot to do content wise (writing transcripts, asking the rightholders for permission to distribute recordings of talks) but I am comfortable having the site online already.

elfeed

Elfeed is a Feedreader for Emacs. It has a great reputation within the community. It fetches the feeds itself by default, but with elfeed-protocol it can sync with different servers like Newsblur or ttrss. Elfeed-protocol has seen some critical improvements over the last few weeks, so I tried it out once more.

Elfeed sits in the intersection of 2 things I love: emacs and RSS. It’s gorgeous and I would love to use it, but when I first tried it in 2020 it missed some (for me critical) features. Those were resolved, some of them just a few weeks ago.

But I am not sure the sync of the read-status works reliably. I will have to try it some more. I am also in the in the process of reading through the code. This is bit hard for me because (e)lisp is still a bit hard for me to read.

hello world in sh

When I write a sh-script, this is how I start:

#!/bin/sh

# usage: ./greeter Johannes

set -eux

set -o pipefail # only works in bash

greet() {

echo "Hello $1"

}

greet "$1"

(Don’t forget to make the script executable: chmod +x greeter)

This template is useful because it encourages good standards.

This post is here mainly so I can find the template whenever I want to write a quick script. But since you are already here, lets go through it, line by line.

What is in the template

Shebang

#!/bin/sh

It allows you to run the script directly (./greeter Johannes) instead of with an interpreter (sh greeter Johannes).

Usage hint

# usage: ./greeter Johannes

A small reminder on how to use the script (because I will certainly forget it).

defensive programming

set -eux

If there is an error the script should stop immediately.

What it does (as described in bash -c "help set"):

-e: Exit immediately if a command exits with a non-zero status.-u: Treat unset variables as an error when substituting.-x: Print commands and their arguments as they are executed.

The last one is great for debugging. If you want to read more about these flags with more context, start reading here.

set -o pipefail # only works in bash

This is a bit of an outsider, because it is bash specific. I try to write my code as POSIX compliant as possible, but I don’t do so religiously. So this can stay in my opinion.

What it does is change the collective exit code of commands that are chained together by pipes.

Lets say you want to list all the home-directories sorted by alphabet.

You would write ls /home | sort and get an exit code of 0: All is fine.

But what if you have a typo in it?

ls /homee | sort will print ls: cannot access '/homee': No such file or directory to stderr,

but the exit code still indicates that all is fine.

That is because the exit code of the chain of commands is just the exit code of the last command - and sort did just fine with no input.

set -o pipefail will make this behave as expected:

The first nonzero status code will determine the status code of the whole chain

(and with the -e from above the script will abort).

Only if every single command exits with 0 then whole command will have exit code 0 as well and the script will continue.

In our case we would get an exit code of 2.

Function definition

greet() {

echo "Hello $1"

}

Define a function in a POSIX compliant way.

The arguments are not declared in the breakets as in python (that would be cool).

Instead they are just assumed to be there and called with $1 (or $2 for the second argument, etc).

Function call and script arguments

greet "$1"

Call the above function with an argument.

The argument could be any string (greet "Sandra"), but I chose to use to forward the first argument of the script.

Script done

Now you can just script away. By the way, make sure to check it for errors with the incredible shellcheck.

Do not sort your screws

I used to have a medium-sized toolbox in my basement. Then recently I got my hands onto a relatively big amount of tools. They were not sorted at all.

From what I can tell the previous owners used to keep the tools in the whatever room they used them in last. “Finished the sink? Just put screwdivers and the leftover sealing rings in the kitchen-box.” I guess it worked for them.

It didn’t work for me. I threw all the piles together and spent multiple evenings sorting. Tools, material, boxes…

Sorting through your stuff is fun. I have been a fan of Marie Kondo since I read her book the first time, so I wasn’t afraid to let go of a lot of stuff. It is a joyfully way to spend a few hours.

One thing I didn’t get sorted out were the screws. There were just too many different ones.

What others do

I looked up how other people sort their screws. High shelves with small boxes, sorted by length, thickness, head type… There are selfmade tools that assist the sorting and big machines that do it all on their own.

All those solutions don’t fit my situation. My screws comes from many years of leftover screws, partly rescued from older furniture repuposed. I don’t have 5 or 10 or 20 kinds of screws, more like 100. At the same time, it is very seldom that I have 10 of the same kind.

I also seldom need a very specific screw. And if I did I probably wouldn’t have it in stock. Most of the time I need “2 Wood screws around this length, not too thick” or “anything with a round head like this”.

What works for me

So everything got into a big pile, in a big open box. Only those screws and dowels that are still in their original package were allowed to stay there. All of this went into a drawer.

This was not exactly a stroke of genius. It was simply the thing that required the least amount of work. For now I was fine with not making the problem worse.

I turned out to work extremely well though.

- doesn’t take a lot of space

- very easy to maintain

- finding a fitting screw is fairly easy (although finding a single certain screw is hard)

- there are practically no sunken costs (no stacking boxes, no rack, no time invested into sorting thousands of small parts), so I am very open to improvements

I sorted them a little bit

After using that system for some time I noticed that I could do a little better. This was mainly because I found that my screws could be divided into two piles very naturally: Wood screws vs Metal screws. So I separated them into two different containers.

I think this works because of two reasons:

- The division line is very clear (so both sorting and searching are easy)

- The resulting piles are about equal in size (roughly a relation 1:2), so the split really cuts down the search space.

For those reasons this divide increased searching speed without sacrificing the spirit of the system. The advantages get hurt just a little bit, but the trade of is worth it in my opinion.

I later split the bigger pile into long screws (>3cm) vs short screws (≤3cm), which works for the same reasons. I don’t think more splits would improve the situation for me, though.

Conclusion

In some situations the best sorting system is not to sort at all. Keep in mind that this is a valid option, too.

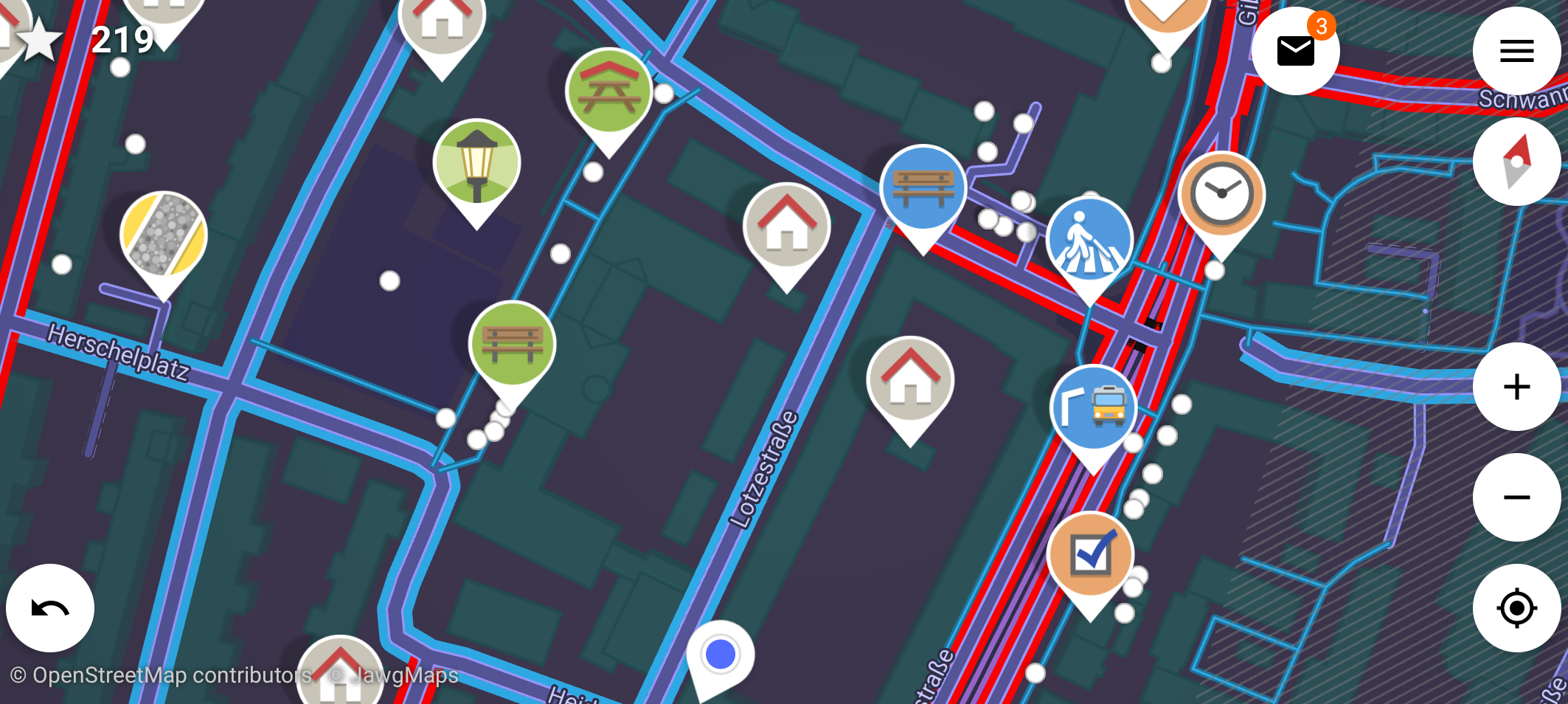

Trying out StreetComplete

The other day I found that StreetComplete is on F-Droid. I had heard of that app when it came out but had totally forgotten about it. Time to give it a try.

How it works

The goal is to go outside and add information to OpenStreetMap from your phone.

The app is probably the most modern app on my phone, it looks like it anyway. You need to login with your OpenStreetMap account (I barely remembered having one). Then you get a map and select an area where you would like to do quests. Those are scattered around in the area and you can choose which one to take. (You can also specify which kinds of quests you would like to do. Personally I don’t like to decide on types of houses and don’t want to measure the width of roads, so I don’t.)

After choosing one you get a simple question with some answers to choose from. Sometimes you are asked to enter some text (a house number or the name of a shop). But mostly the questions are multiple choice, with illustrated answers. This makes deciding on the right answer much easier.

Common questions in my area (gnihihi) are:

- Is there a sidewalk on that street?

- What kind of surface is here?

- Is there a bench/trashcan/streetlight at this bus stop?

- Is that sign still there?

Once you have answered the question the answer is directly uploaded to OpenStreetMap. You can even do it without mobile data! Then the answers are uploaded when you have WiFi next time. Awesome.

How it feels

It reminds me of those augmented reality games (Pokemon Go from 2016, Ingress from 2014) that were very in a few years ago. I never played those, but I imagine they felt similar to this.

Everything about the app is fun. Answering simple questions is fun, getting outside to clear your area from quests is fun, walking into random streets for some quest is fun. The kids like it, too. We were having a lot of fun with it.

Once you uploaded your answers you can have a look on OpenStreetMap and see them in the map right away. This in turn made me do some editing on the Map in the browser as well. OpenStreetMap’s Browser Editor (called iD) is really good these days, and so is the wiki where all the tags are explained in detail. And iD will even link those wikipages on within the editor so you can look them up effortless.

When I started contributing to OpenStreetMap I often was afraid that I would label something wrong and ruin the map for everyone. But in StreetComplete the quests are well chosen. The questions are direct and the options are clear, so you can answer confidently. And if you think you did something wrong anyways you can undo your answer.

Conclusion

After 3 days with StreetComplete I now have cleaned up the small area where I commute regularly. Some tasks can even be done from the bus, if you are quick. On occasion I will have to explore other areas.

StreetComplete does a good job at lowering the barrier of entry for mappers. I love it.

Annoyed with Sir Arthur Conan Doyle

My wife and I read stories to each other. It is a great way to go to sleep. At some point we started to do the Sherlock Holmes books by Sir Arthur Conan Doyle. A faithful translation of the originals.

The books are fun.

- The mysteries are interesting.

- Having read the originals (or a good translation) shines a new light on the many many adaptations that we are out there. A lot of them play with the original texts.

- The moments where Holmes goes “I know everything about that person just from having a close look” are always fun.

- Sherlock Holmes is in public domain. This gives me a feeling of opportunity - I could do everything with the material. (It is more of a theoretical opportunity though, I am not in the business of adapting literary figures.)

It is clear that crime novels have come a long way since 1887.

- Some of the situations/conversation feel a bit set up. Watson is constantly super-surprised about Holmes deductions. One would expect that he would learn to expect them (even when he can’t do them himself).

- Some of the solutions feel trivial. This is probably unfair against those stories, but by today’s standards I expect a clever and complex solution to a mysterious problem. “It was some guy who wanted the money, so he just did the next best thing” is just not interesting.

- Some ideas have been reiterated on so often that they feel old and predictable. Once again, this is not the originals fault, more of an achievement.

But there is one thing about the story structure that really annoyed us.

It happens at the end of some cases. The culprit has been found and arrested, it is more or less clear what happened. Holmes has had all his moments of cleverness. Now all we need is something to conclude the story.

But then the culprit gets a backstory. And that backstory is told in very much detail. Either by himself or just by the narrator. That’s fine and all, but it doesn’t add to the action. It is just another plot, nearly completely unrelated to what the book is about.

Examples would be:

- Chapter 12 of “The Sign of the Four” (1887)

- Chapter 1 to 5 of the second part of “A Study in Scarlet” (1890)

(I will admit that this seems to be only a problem of the earlier books.)

It feels like the author had thought of this backstory for the baddie and - when he finished writing - noticed that he did never use it in the tale. So instead of working it into the text he just pasted it in at the end, like an appendix.

This takes away from the books flow, and it makes me sad because I like them a lot.

It’s fine though, the later books don’t have the problem (or at least to a lesser extend).

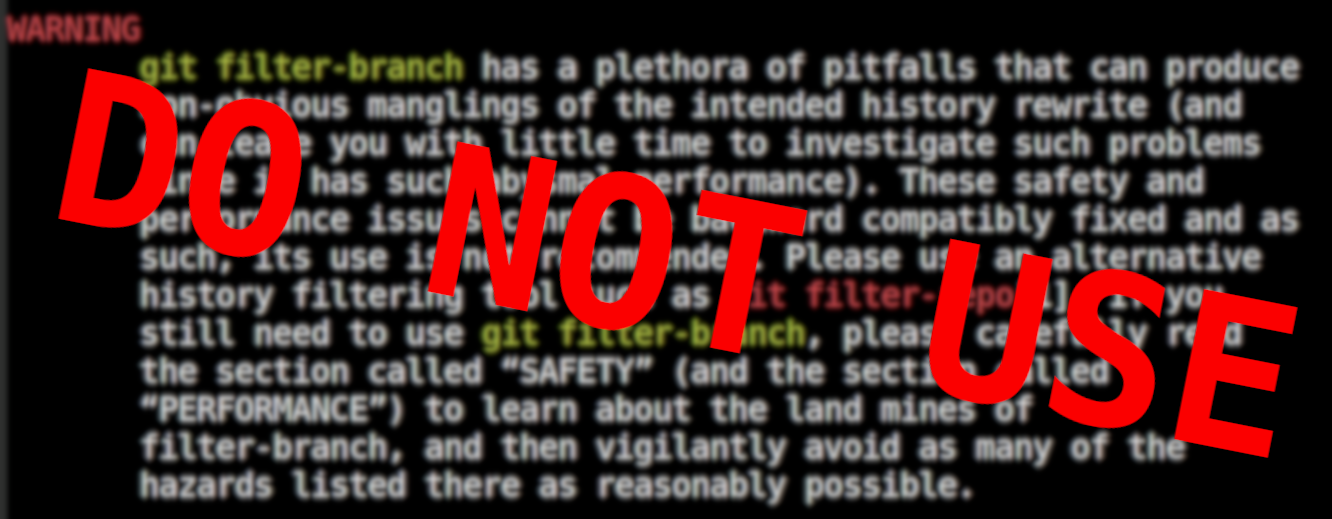

Do not use this software

There is a piece of software on your computer that you shall not use.

It is not broken or alpha-software, it works perfectly fine. It is part of git after all, the basis of almost all modern and not so modern software. But have a look at it’s manpage and you will find a big warning to please not use it.

I am talking about the command git filter-branch.

Just have a look at it’s manpage.

I quote:

WARNING

git filter-branch has a plethora of pitfalls that can produce non-obvious manglings of the intended history rewrite (and can leave you with little time to investigate such problems since it has such abysmal performance). These safety and performance issues cannot be backward compatibly fixed and as such, its use is not recommended. Please use an alternative history filtering tool such as git filter-repo[1]. If you still need to use git filter-branch, please carefully read the section called “SAFETY” (and the section called “PERFORMANCE”) to learn about the land mines of filter-branch, and then vigilantly avoid as many of the hazards listed there as reasonably possible.

I read a lot of documentation: manpages, infopages, html-manuals, api-references, docstrings and (occasionaly) even as books. But I don’t remember reading about a piece of software that tries so hard to convince you to not use it, while simultaneously being available on nearly every computer in the world.

I found that quite amusing.

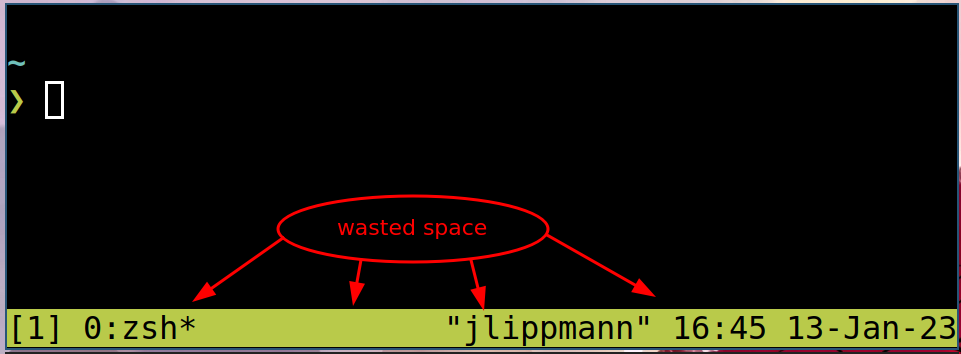

Hide the tmux statusbar if only one window is used

What?

I want the tmux statusbar to show only if I have multiple tmux-windows open. When only one tmux-window is open, then the status bar should be hidden.

Why?

I like tmux, it is awesome. But I don’t use it in most shell sesssions.

My window manager (swaywm) is very good at creating and closing terminals. I often spawn them for a quick command and close them after a few seconds. So most of the time I do not need tmux in my terminals.

On the other hand, tmux features a big shiny green statusbar. That is usefull if I want to manage multiple tmux-windows. But if I don’t do that, then the status bar is distracting and takes up valueable space. Therefore I do not want that in every terminal I spawn.

Then again sometimes I am kneedeep into some project and then would like to use some tmux features. But at that time it is somewhat too late.

The best solution would be to have tmux running in every terminal, but have the status bar only show up if I start using multiple tmux-windows.

How?

Showing or hiding the statusbar permanently is as easy as adding one of the following lines to the tmux config file:

set -g status on

set -g status off

I was supprised to find out that automatically hiding the status bar doesn’t seem to be a very common thing to want. I didn’t find much on this, but it was quickly clear that I would have to use hooks and conditionals.

Then I found a github issue about my very usecase. The solution they suggested did only work half of the time unfortunatelly. (It failed to hide the statusbar when you would have multiple windows and start closing them from the left.) But I did manage to get it working by adding more hooks.

Here is the relevant part of my tmux.conf

# only show status bar if there is more then one window

set -g status off

set-hook -g after-new-window 'if "[ #{session_windows} -gt 1 ]" "set status on"'

set-hook -g after-kill-pane 'if "[ #{session_windows} -lt 2 ]" "set status off"'

set-hook -g pane-exited 'if "[ #{session_windows} -lt 2 ]" "set status off"'

set-hook -g window-layout-changed 'if "[ #{session_windows} -lt 2 ]" "set status off"'

Hooks are a bit of a pain in tmux, I wasn’t able to get a list of all active hooks. Closing the tmux session wouldn’t reset the hooks already set. So I had to reset the hooks by killing tmux (not just the session, tmux itself).

Done

So now I can have tmux active in every terminal I open. It won’t show the status bar if it is not needed, only if I have more then one window. I am quite happy with this new setup.

I quit Social Media

I get addicted to social media quite easily. It doesn’t do me good, I tend to sink a lot of time into it.

I usually use only one network at a time. I have had accounts on:

- Facebook: because all my classmates were there

- Twitter: because people there were so funny

- App.net: because Tim Pritlove promoted it

- Reddit: (because many interesting communities live there)

Each of those was hard for me to quit.

I also tipped my toes into the Fediverse, a collection of decentralized social networks: GNU social (almost the same as Mastodon today) and Friendica (which I even hosted myself). While there were some very interesting communities there (mostly nerds and trans-people) I never got hooked enough to stay. The reason might be that those networks don’t work so hard to make you addicted to them, which is a good thing.

What I didn’t quit yet

I still watch a lot of Youtube, but I don’t “like”, “subscribe” or “comment” there, so it is not really a social medium for me, just a medium. I use it as a portal for video-podcasts. At some point I will probably have to reduce this, too.

I read a lot of Blogs (and similars) via my feedreader. The open web is just the best. And I don’t think I will ever want to stop that. My share of it is this blog you are reading right now.

I do use mail, messenging and phones. But those are not social media to me, I would call them social networks.

How to quit

From time to time I realize that I have a problem with an addictive website. And some time later I get a “It’s time to quit”-moment. What works for me then is quiting cold turkey, by doing some of those:

- Log out on every device

- Delete the account

- Delete the site from my browser history (so I don’t get suggestions when typing an url)

- Block the site via DNS

- Tell my wife/friends that I quit

This has worked well for me, and after a week or so I rarely feel the need to go back.

Blogging on mobile

I want to write and publish blog posts from my mobile (which is running Android).

what is needed

Since this blog is being generated using a SSG in a CI from markdown files which life in a repo, this means I need to do the following:

- Clone a private repo from gitlab

- Add markdown/image files to the existing ones and edit them.

git addthose files to the repo andgit pushit to origin.

The CI will do the building and publishing itself then.

I want to use only free software if possible. Especially I don’t want to use any google services like the Playstore.

Let’s go through the points inorder:

1. Clone a (private) repo from gitlab

I was optimistic that there would be a capable git client on fdroid, but I couldn’t find anything suitable. There are some vendor specific clients (like GitNex for Gitea) and git-touch looked promising (but turned out to be a tool for managing accounts, not repos)

So I went for tmux (basically a terminal with a shell for Android) and installed git by hand. It doesn’t feel very polished for mobile but at least it is a shell and I can do what I want there.

To authenticate against gitlab I created a personal access token with the scope “read_repository” and “write_repository”. Then I could use special gitlab-magic-syntax to use this token in the branches path:

git clone https://gitlab-ci-token:{TOKEN}@gitlab.com/Kaligule/schauderbasis.git

There I had my repo.

2. Add images and markdown files

There are plenty of useful image-/markdown-editors on fdroid. Notes seems to fit my usecase very well.

I had some difficulties getting the paths right in tmux. I chose to blame android and java for this. Long story short: I had to call

termux-setup-storage

in termux and move the repo into what android seems to use instead of a home directory. Strange. But now all the apps can agree on where the repo is.

3. Perform a git add and git push

We basically did all the work in step 1. Just fire up tmux and type. I didn’t find an app that could even do these simple tasks.

this post is a proof of concept

Literally. I did this whole post on my mobile.

it doesn’t feel great

Honestly, it works but it still sucks. Working with a touch keyboard as the main driver on every step is no fun. But at least everything is under control and I can replace the tools until I am happy with them.

Write a program that reproduces itself

If you like to program, here is a neat little excercise:

Write a program that outputs it's own source code.

It is really fun, you should try it now. For me it is the kind of excercise that won't leave your head once you have written the first line of code.

Spoilers ahead.

How I did it

Python

I am most fluent in python, so that's what I tried first. After some trial and error I had this, which got me pretty close:

var='x'

print(f'{var=}\nprint({var})')var='x' print(x)

Now all I had to do was to find good value for var and hope that the escaping would work out.

I ended up with this.

var='print(f"{var=}\\n{var}")'

print(f"{var=}\n{var}")

var='print(f"{var=}\\n{var}")'

print(f"{var=}\n{var}")

You can check that this really does output it's own source code by putting it into a file and running (in bash):

diff code.py <(python code.py) && echo "Success"This was fun, but I did use a bit of f-string magic. Can we get a similar solution in another language?

sh

Solving a problem in a shell-script is either really easy or really hard. Lets find out:

var='x'

echo -e "var='$var'\n$var"var='x' x

The first attempt works reasonably well,

but when we replace the string x with echo -e "var='$var'\n$var" then we get into trouble.

var='echo -e "var='$var'\n$var"'

echo -e "var='$var'\n$var"var='echo -e "var= $var"' echo -e "var= $var"

As always when you work with complicated strings in shell scripts, escaping special characters becomes unreasonable difficult.

In the end, I couldn't get it to work.

How to google it

A program that prints it's own source code is called a quine.

You may now google it, or just read the wikipedia article (which is great). I especially enjoyed the cheating section, where it mentioned that an empty program is technically a valid quine, as it outputs nothing when executed.

There is also rosetta code, which lists many solutions that I don't understand and some cheats.

How much control over the problem do you have?

There is a problem and a team who should do something about it. That team wants to communicate to others how much control over the problem they have. So they draw a scale, we will call it the problem-under-control-scale.

Here are some points they might mark on it (sorted roughly from bad to good):

- We don’t know there is a problem.

- We suspect there is a problem.

- We know there is a problem.

- We know there is a problem and how bad it is.

- We know there is a problem and how to find out more about it.

- We know where the cause of the problem lies.

- We were able to reproduce the problem.

- We know the cause of the problem.

- We understand the problem.

- We are looking for solutions.

- We know there is a solution.

- We know where to find a solution.

- We have an idea how a solution might look like.

- We are choosing between multiple apparent solutions.

- We know how we want to solve the problem.

- We are implementing a solution.

- We are testing a solution.

- We have solved the problem for now.

- We have solved the problem.

- We have solved the problem and learned from it.

- We have solved the problem and documented our learnings.

- We made sure problems like this can be solved easily in the future.

- We made sure problems like this can not happen anymore.

(I am sure there are more possible steps. For example, what if additional help is needed at any point?)

What to use the problem-under-control-scale for

I like this problem-under-control-scale, because it allows to think about problems in an abstract way.

- One of my favorite topics for talks/blogpost is “How we once improved our position on that scale”.

For example:

- “How we went from

We know there is a problem.toWe have solved the problem..”

- “How we went from

- In your teams’ update meeting you probably like to talk about

We are choosing between multiple apparent solutions.or better. But really important would be to talk about everything worse thenWe understand the problem.. - Quite often people stop when they got to

We have solved the problem for now., when they really should push further down the scale. - Open your favorite news-site. Most of them articles will be about problems. At which point are they on the problem-under-control-scale?

- You could also try to categorize posts on social media this way.

- Note how the first third of the scale doesn’t mention solutions at all. Don’t jump to solutions straight away. Sometimes knowing the problem might even be enough.

- Most ads try to sell you a solution to a problem you didn’t really have

(at least you made it so far without the advertised product).

So they have to get you from

We don’t know there is a problem.all the way to at leastWe know where to find a solution.(but not accidentally toWe have solved the problem for now.or better, because that wouldn’t sell anything). Try to see how they manage that next time you see an ad. - Most jobs pay so the employee solves some kind of problem.

When you get a problem to deal with, where is it on the

problem-under-control-scale? Close toWe suspect there is a problem.? (You are a detective then, cool!) Or more atWe know how we want to solve the problem.? (… and we want you to implement that solution)

What else could we do with the scale?

I think you could get some nice graphs if you pair the problem-under-control-scale with some other scale. Time perhaps? Or costs? Expertise_needed?

You would then plot the the course of your problems on the resulting coordinate system. This could help to answer questions like:

- Which step in the problem solving journey takes the most time/effort?

- Where do you get stuck most often?

- Should you perhaps approach your problems in a different way to get stuck less often?

Meine Quellen für die Welt der freien Software

Ich komme zur Zeit nicht viel zum schreiben. Dafür gibts gute Gründe, aber manchmal macht es mir etwas aus. Es ist auch nicht so, dass es nichts zu erzählen gäbe, aber die Zeit…

Naja, hier ist eine kurze Liste von Feeds, mit denen ich mit der Welt der freien Software in Kontakt bleibe. Selbst dann, wenn ich wenig Zeit habe.

Blogs, die häufig geupdated werden.

- GNU/Linux.ch: Meine Lieblingsnewseite zur Zeit. Sehr offene Community, richtig stark. Für mich ist es ein gefühlter Nachfolger von Pro-Linux.

- Linux News

- Emacs news (english): Die Emacs Community ist stark, aber auf viele Plattformen verteilt. Die unsterbliche Sacha Chua sammelt einmal die Woche alle interessante Sachen zusammen. Podcasts:

- Binaergewitter: Laberrunde mit fittem Team, die viel Informationen zusammentragen und einordnen.

- Python bytes (english): Die finden alles amazing, solange nur das Wort “Python” darin vorkommt. In eigentlich jedem Podcast sind ein oder zwei feine Fundstücke drin.

- Radio Tux: Fühlt sich ein bisschen wie ein Magazin an. Auf dem Radar:

- LinuxWeeklyNews (english): Einer der sehr wenigen bezahlten Feeds, die für mich attraktiv sind. Sehr technisch und sehr in die Tiefe.

Außerdem floge ich noch etwa 150 privaten Blogs (zb Xe Iaso, Drew DeVault, Brian Moses ) und den “offiziellen” Blogs von etwa 80 Projekten, die mich speziell interessieren (zb Godot, Thunderbird, Neovim ) Jeder schreibt selten, aber zusammengenommen gibt es jeden Tag was zu lesen.

(So vielen Quellen gleichzeitig zu folgen ist natürlich nur möglich, wenn man RSS/Atom-Feeds benutzt.)

Wenn ich das hier so aufschreibe fällt mir auf, dass fast alle deutschsprachig sind. Eigentlich cool, dass es da so viel deutsches Material gibt. Ich wäre aber auch an mehr guten englischsprachigen Blogs interessiert.

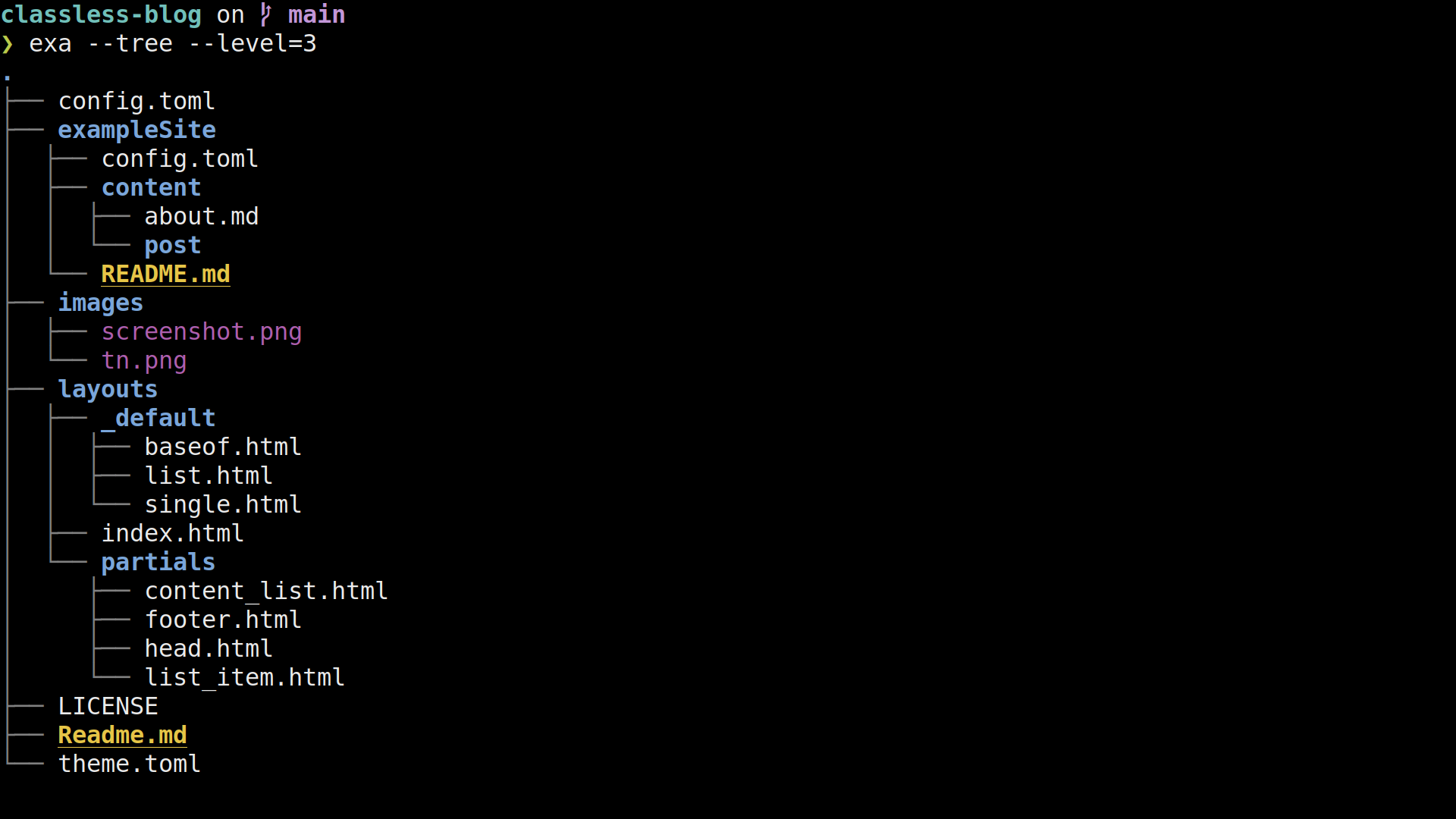

I wrote a hugo theme

I just love the concept of static site generators (SSG) for websites. They allow to separate content and presentation really cleanly:

- content is defined in some textfiles using some markup language

- the presentation is defined in

- a configuration file that sets some global metadata

- a theme, which is mainly a bunch of templates and css and potentially some JavaScript.

My blog has been generated using a SSG (namely hugo) for a long time, during which I switched between quite a few themes.

the most minimal theme

I always wanted a blog-theme that was as simple as possible. There are a lot to try, but I never found something that fitted me perfectly. I don’t want Integration of Google Analytics or Disqus or any other third party. I don’t want to need a cookie banner because I don’t use any cookies. This is not a social media platform, it is a blog and I started it for a reason.

But I was also aware of how little I know about JavaScript and CSS. And about design. So building a theme myself seemed to be out of reach for me.

But then, some time ago I revisited motherfuckingwebsite (and it’s many successors) and even though I can see the satire I wanted my blog to be somewhat like that. This seemed doable.

So I wrote some html-templates. It worked somewhat well but there was no denying that the black-and-white aesthetics of bare HTML was hard on the eyes.

nice css that I don’t have to write myself

Around that time I rediscovered classless css themes. Basically a classless css theme is a bit of css that is designed to make generic HTML look good. Generic HTML means that there don’t need to be special classes in it, just the standardized html5 tags. There are quite a lot of these themes available on the internet, most under free licenses. This was exactly what I needed.

I added a single configuration setting to my theme: It determines which classless theme you want to use. I added a sensible default and documented everything. I also let the user of the theme decide whether they want to load it from the web on each visit or whether they want to host it themselves.

And there we are: A theme for Hugo. Flexible in it’s looks, minimal in it’s design and beautiful in my opinion.

Some things I learned on the way

-

HTML is really expressive. I had assumed that markdown was about as powerful as Markdown. I was clearly wrong: there are soo many HTML tags for all sorts of things. My favourite finds include:

-

Hugo’s documentation is hard to use. I really wish it was decided into different sections for what I assume are it’s three main target groups: website-builders, theme-builders and hugo-developers.

-

I really wished to find a set of best-practices for building themes. Instead you are on your own with all the opinions of the internet as your best guideline. This also shows when you try to switch between themes: You almost always have to adapt some config that is specific to the implementation of that theme only.

-

The theme format and ecosystem of Hugo both have great parts that are simple and powerful (like the

theme.tomlor how thelayoutsdirectory is structured). Other parts look like the result of yearlong growth and people doing “whatever works” (like the requirements for themes). -

For the demo site I needed some cool images. I found a lot on unsplash and it was fun to collect unrelated images that fit together.

-

It is hard for me to know if a site is accessible or not. There are some web services that will score your site automatically, but I don’t really trust those. So for now I will just browse the site with a command line browser (lynx or w3m) and if that works well I feel like I have done enough. I am especially happy about constructive feedback in the point.

-

putting together a theme is one thing, finishing it as a project is a lot more work. You know, like doing a public repository, the demo site with nice pictures under free licenses, the documentation, a license, testing, CI/CD etc. But having done all that also means that I can be sure that it will continue to be usefull AS it is, not just a bunch oft dead code that nobody can get to work anymore.

reformat paragraph

Lets say we have a paragraph1 of plain text - probably in a markup language like Markdown, Orgmode, Asciidoc or LaTeX.

Then there are 4 sensible ways this paragraph can be formated:

- unfilled

- Everything is in one line. This can be achieved using the

function

unfill-paragraphin purcells unfill package. - filled

- Every line has at most

xcharacters 2. This makes a mass of text look uniform and prevents horizontal scrolling. This can be achieved with the functionfill-paragraph. - one-sentence-per-line

- This works very well for version controll, especially if the text is in some markup language. Diffs of small changes look very nice and readable. This format can be achieved with the custom function fill-senteces-in-paragraph I wrote below3.

- custom

- If the author wants it in his very specific way then nothing should stop him from formatting his text as they wants. Obviously this can not be done by the editor.

Here is an example of how they would look like in a text:

Unfilled: Lorem ipsum dolor sit amet, consectetur adipiscing elit. Sed do eiusmod tempor incididunt ut labore et dolore magna aliqua. Ut enim ad minim veniam. Quis nostrud exercitation ullamco laboris nisi ut aliquip ex ea commodo consequat.

Filled: Lorem ipsum dolor sit amet, consectetur adipiscing elit. Sed

do eiusmod tempor incididunt ut labore et dolore magna aliqua. Ut enim

ad minim veniam. Quis nostrud exercitation ullamco laboris nisi ut

aliquip ex ea commodo consequat.

One sentence per line: Lorem ipsum dolor sit amet, consectetur adipiscing elit.

Sed do eiusmod tempor incididunt ut labore et dolore magna aliqua.

Ut enim ad minim veniam.

Quis nostrud exercitation ullamco laboris nisi ut aliquip ex ea commodo consequat.

Custom: Lorem ipsum dolor sit amet,

consectetur adipiscing elit.

Sed do eiusmod tempor

incididunt ut

labore et

dolore magna

aliqua. Ut enim ad

minim veniam. Quis nostrud

exercitation ullamco laboris nisi

ut aliquip ex ea commodo consequat.

So the first 3 formates can be done by emacs directly. Building on the

results of the article "Fill and unfill paragraphs with a single key"

on https://endlessparentheses.com I want a single keybinding (M-q)

that cycles the paragraph through all of those fomattings.

This is great for 4 reasons:

- I can keep my existing muscle memory where

M-qisfill-paragraph, because we are basically building an extention to that command. - We don't loose functionality because there is no reason to call

fill-paragraphmultiple times in a row anyways4. - I only have to commit a single keybinding for reformating (keybindings are hard to remember well and short keybindings are rare for emacs users).

- I can repeatedly press the

M-quntil I like the formating. This allows me to go through the formattings quickly and see what I like best.

Having one keybinding cycling the text through different states is not very common in emacs, but it is not unheared of either:

recenter-top-bottom(bound toC-lby default) cycles through different views of the same buffer.org-cycle(bound toTABin orgmode) does rotate through different views of subtrees.

So lets try to build this.

Get all the formating functions

First we need to have a funtion for each format that reformats the current paragraph into that format.

The function fill-paragraph is conviniently built into emacs. For unfill-paragraph we can just use this package.

(use-package unfill)Now fill-sentences-in-paragraph we will have to write ourselfs:

(defun fill-sentences-in-paragraph ()

"Put a newline at the end of each sentence in the current paragraph."

(interactive)

(save-excursion

(mark-paragraph)

(call-interactively 'fill-sentences-in-region)

)

)

(defun fill-sentences-in-region (start end)

"Put a newline at the end of each sentence in the region maked by (start end)."

(interactive "*r")

(call-interactively 'unfill-region)

(save-excursion

(goto-char start)

(while (< (point) end)

(forward-sentence)

(if (looking-at-p " ")

(newline-and-indent)

)

)

)

)

Note that using forward sentence means that emacs needs to know how your sentences look like.

Read the documentation on sentences, especially the part where sentences are/aren't followed by a double space5.

Cycling through the functions.

Now we need a function that behaves different on consequtive calls.

(defvar repetition-counter 0

"How often cycle-on-repetition was called in a row using the same command.")

(defun cycle-on-repetition (list-of-expressions)

"Return the first element from the list on the first call,

the second expression on the second consecutive call etc"

(interactive)

(if (equal this-command last-command)

(setq repetition-counter (+ repetition-counter 1)) ;; then

(setq repetition-counter 0) ;; else

)

(nth

(mod repetition-counter (length list-of-expressions))

list-of-expressions) ;; implicit return of the last evaluated value

)

We can try this out by running (cycle-on-perpitition '("a" "b" "c")) a few times.

The result is (as expected): a, b, c, a, b …

I especially like the thought that even though repetition-counter is a

global variable and there is only one of them, we can use

cycle-on-repetition in different commands and the repetition-counter

will only ever count the repeats of the last envoked command. That is

because the switch is detected when this-command and last-command

are compared.

Putting it together

Now we can use a list of functions (functional programming, yeah!), cycle through those and call the result each time.

(defun reformat-paragraph ()

"Cycles the paragraph between three states: filled/unfilled/fill-sentences."

(interactive)

(funcall (cycle-on-repetition '(fill-paragraph fill-sentences-in-paragraph unfill-paragraph)))

)

And finally we bind that to M-q, to replace/extend emacs default behaviour.

(global-set-key

(kbd "M-q")

'reformat-paragraph

)Badabing Badaboom, our function is live. I use it very often when writing texts (like this blogpost) in emacs.

Some notes:

- I am quite proud of

cycle-on-repetition, it is one of the first complex behavours that I implemented in emacs-lisp all by myself. - my emacs config is public so you can have a look to see if this code is still part of it or not.

- If you liked this idea,

follow me on insta…then try to reimplementrecenter-top-bottomusingcycle-on-repetition.

A paragraph is one or more senteces separated from the rest of the text by two or more newlines.

x is controlled by the variable fill-column

There are many versions of similar functions around, I chose one that worked best for me.

The article on endlessparentheses calls that a "free feature"

This is a holy war I wasn't aware of.

entr should be part of every linux installation

If you use the commandline as your IDE, then entr is super usefull. As most unix programms, it does exatly one thing: “Run arbitrary commands when files change”

The syntax goes like this:

NAMES_OF_FILES_TO_WATCH | entr ENTR_FLAGS COMMAND COMMAND_FLAGS

Example usage

The entr website lists a bunch of usecases and examples, some are quite elaborate.

Here are some of the things I do with entr:

Export a markdown file to pdf and reexport it so that it is always up to date

Many converter tools

(like latexmk, hugo and diagramms)

have a flag that makes them watch for changes in files (and do their thing then).

But this doesn’t feel like it should be in there.

Why would they all reimplement the same functionality?

Using entr feels more natural and is more composable.

ls thesis.md | entr pandoc --to pdf thesis.md

find . -name "*.md" | entr -c hugo # I am using this line while writing this blogpost

Have a self-updating list of all TODOs in my org-file

echo "thesis.org" | entr -c rg TODO /_

This is nice when you are killing TODOs in your project and want to have a small “dashboard” of the remaining ones.

(the /_ will be with the name of the file that changed)

Run the testsuit when I changed the code or tests

Whenever I have some tests failing I use this command so I don’t have to restart the test after every attempted.

find . -name "*.py" | entr python -m pytest

continously try out my script

ls nondestructive_script.bash | entr -c bash /_

This will run the script whenever I change it (which is nice as long as I am sure that the script doesn’t do something terrible). I can then examin the output and adapt the script.

entr is very unixoid

I really wish it was preinstalled on all unixoid systems. It fits so well into the ecosystem:

- It works on files

- It works on text

- It doesn’t produce any output (unless you ask it to)

- it composes well with other programs as stdin (especially

ls,findandgrep --files-with-matches)

The only strange thing is that the files to watch are specified through stdin.

The interface doesn’t feel like a filter that way, a bit like xargs cat

But one gets used to that.

entr plays especially well with make (because make only acts on files that have changed).

entr a bit more Meta then other commands

entr is a meta command, it is intended to call other commands.

This distinguishes it from familiar programms like tail, wc, sort, uniq, curl etc.

and puts it more in line with watch, time, xargs and sudo.

entr is the best

I really like to have entr around. Luckily it is available for allmost all linux distros and even macOS.

I speak nix now

After living in a love-hate relationship with my nixos-configuration it finally came to the point that it became too big of a file to handle. I already had it versioned (nearly everything I write is versioned). But now the file approached a few hundred lines at I was going to loose my grip on it.

A few hundred lines of code is nothing. But a few hundred lines of config is a whole lot. Especially if you don’t know the configuration language well. Or if the config is about very different aspects of a complicated system.

I know I had to find a solution. There were two obvious ones:

- Manage the config in org-mode (literate-config-programming) as I do with my emacs config.

- Learn more about the nix-language and split the file up into modules.

I knew I would have to make a decision and I dragged it around with me for about a week. Then a night came where I couldn’t sleep and I used it to read a lot about nix, especially this article. And finally it clicked.

I had a breaktrough.

When I finally understood how import function works in nix I was blown away in a storm of motivation.

Over the next days I rewrote my config into a series of modules, nice and separated.

(I can only work in the evening on stuff like that, often no more then 20 minutes a day.)

I learned a lot about nix in the process, a lot of pieces fell into their place.

Now my laptop and my server share many modules and it is easy to add new ones without adding much complexity.

It feels great.

This has happened before. I declared emacs-config-bankruptcy multiple times before I finally got it and brought it all into a nice, organized format. Since then the config grew and grew, is counts 2000 dense lines of config and holds over 40 chapters on minor-modes alone. Yet I don’t fear touching anything in it. I even read other peoples configs from time to time, taking good ideas from them.

My emacs config is under control. And now my nixos-config is, too.

Proof of concept: Backup from Unix to Nixos with Borg

I want to get a directory backed up with borg on my nixos-server (regulus.fritz.box).

The client may just be a regular unixoid, doesn't have to be nixos (I am using MacOS for testing).

All the commands (unless explicitly stated otherwise) are executed on the client.

Both systems have borg installed.

This is a tutorial, so most explaining will be about what to do, not why to do it.

Setup

We first create the directory with our valuable data.

echo "1234567890" > files_to_back_up/zahlen.txt

echo "abcdefghijklmnopqrstuvwxyz" > files_to_back_up/buchstaben.txtFor borg to access the server without a password we need to create a keyfile pair (on the client). Name it however you want.

ssh-keygen -N '' -t ed25519 -f key_backups_of_NUE-MAC-087_id_ed25519Generating public/private ed25519 key pair.

Your identification has been saved in key_backups_of_NUE-MAC-087_id_ed25519.

Your public key has been saved in key_backups_of_NUE-MAC-087_id_ed25519.pub.

The key fingerprint is:

SHA256:KAkg+ve2A+D9TWYYdlshCIECDfP3SWAXAyml8NkZFPA jlippmann@NUE-MAC-087

The key's randomart image is:

+--[ED25519 256]--+

|Oo.=@*+o |

|+*+*.=... . |

|..*.E . . . |

| ..o +oo. . |

| ..o+.++So |

| ..oo. = |

| oo= |

| .o.. |

| .. |

+----[SHA256]-----+Have a look at the public key:

cat key_backups_of_NUE-MAC-087_id_ed25519.pubssh-ed25519 AAAAC3NzaC1lZDI1NTE5AAAAIE+u6Q/ycvxM1XG7JitWqla/nTKvT29rHS9IUjZMaPwH jlippmann@NUE-MAC-087Now we tell the server about this key and what should be done with it. Nixos will do all the complicated stuff for us (creating a user and paths, setting the rights correctly), we just have to add the following to the (server-)nixos-configuration.

services.borgbackup.repos = {

my_borg_repo = {

authorizedKeys = [

# Here goes the public key we just created

"ssh-ed25519 AAAAC3NzaC1lZDI1NTE5AAAAIE+u6Q/ycvxM1XG7JitWqla/nTKvT29rHS9IUjZMaPwH jlippmann@NUE-MAC-087"

] ;

# where the backup will be placed

path = "/var/lib/my_borg_repo" ;

};

};Rebuild and switch. A user of the name borg has been created, has been assigned the mentioned directory and the key has been placed in the correct spot. You can check that this worked like this (still on the server):

cat /etc/ssh/authorized_keys.d/borgcommand="cd '/var/lib/my_borg_repo' && borg serve --restrict-to-repository . ",restrict ssh-ed25519 AAAAC3NzaC1lZDI1NTE5AAAAIE+u6Q/ycvxM1XG7JitWqla/nTKvT29rHS9IUjZMaPwH jlippmann@NUE-MAC-087Initialize the backup

We will have a password, which is the password for our backup itself. To be more precise: it is the password for a key stored in the backup-repo with which the backup wil be encrypted. It has nothing to do with the keypair we created earlier (which is just for connecting to the server). To safe time we will export this backup-passwort to a shell variable beforehand. There are other ways, for example setting a BORG_PASSCOMMAND. If you don't you will be asked to enter the password each time interactively (which is nice for exploration but bad for scripting.

export BORG_PASSPHRASE="test"Now back on the client we can init the borg repo. Note especially the trailing colon and dot in the adress.

borg init --encryption=repokey-blake2 --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.By default repositories initialized with this version will produce security

errors if written to with an older version (up to and including Borg 1.0.8).

If you want to use these older versions, you can disable the check by running:

borg upgrade --disable-tam ssh://borg@regulus.fritz.box/./.

See https://borgbackup.readthedocs.io/en/stable/changes.html#pre-1-0-9-manifest-spoofing-vulnerability for details about the security implications.

IMPORTANT: you will need both KEY AND PASSPHRASE to access this repo!

Use "borg key export" to export the key, optionally in printable format.

Write down the passphrase. Store both at safe place(s).To confirm that we indeed created the repository remotly we can check that the repo was created on the server:

ls /var/lib/my_borg_repo/config data hints.1 index.1 integrity.1 nonce READMEBack on the client again, lets do this key export that was mentioned after we initialized the repo. I THINK that key is what the repo is encrypted with.

borg key export --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:. test_export

cat test_exportBORG_KEY ab6cb44a7ed5b13e6bb9fd62e93731d741de161d031aa74c5e903a7c1e9cb9ef

hqlhbGdvcml0aG2mc2hhMjU2pGRhdGHaAZ5SR2ULbAiQQxcmb1tD+y99ZEzBll9Pe/D0C0

dlQAniuUFgHa2J/dCH3FNkT92QfzgQW3k/SP6obl5JOYRUJRGEPJNYa2RwcSquV9xpqnTg

/QsOWNJQuQBX2dZIMWRiHYVKvXiK11jPI0HyO1c8SV9YgfH8mJtWd+0uX4eLnqCFGBWXfO

hTgKMdRTtkcV89HjZqYI4fW64AnSB6DLPyQutm0jXeRFdYtdZbujufS5SRb9rBYxcypOSu

8TT5zNcu+Sus2vr5gc303CXM9Ktv8wYiuErC6YlP5dClfU8N9ihqS91lIc32R1QbufTSgt

h0yBEugYqGLRDr+ZVGVdwojshgQoyECH9l87FNyQnExvFXm2TNg0O8gWwnja+xNU+0yta5

DNG2tHmCi99Et10ezKton6MXIGcWBwErFlZ5E+vG1pmP3AiUVM7gtUCICp/foJWhoQKlf5

U8xUDid/t34/YGv9kHAWpvXWVQej1lAC4kpaVQ+ZcyGOSN9VUKCniOmbF1ip2cymF0biYn

CnOR5G1Bwc+XSbLlVmUR/xwIJOakaGFzaNoAIAEIyyWhmLMISUJYyy2Iay4O9o7cffYSzR

mUjalZJFK9qml0ZXJhdGlvbnPOAAGGoKRzYWx02gAgpY+xYO83BALtVodzGH4aJgpD6jzt

5Ao3IMLckcx5xeSndmVyc2lvbgE=Create a backup

Now we can do our first backup:

borg create --stats --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.::01_first_backup files_to_back_up------------------------------------------------------------------------------

Archive name: 01_first_backup

Archive fingerprint: e40e34c423ed1dba3ab1243840a3840b244f0f423f8bc96e50773879ae3184cd

Time (start): Sat, 2020-12-26 22:13:26

Time (end): Sat, 2020-12-26 22:13:26

Duration: 0.04 seconds

Number of files: 2

Utilization of max. archive size: 0%

------------------------------------------------------------------------------

Original size Compressed size Deduplicated size

This archive: 1.20 kB 1.12 kB 1.12 kB

All archives: 1.20 kB 1.12 kB 1.12 kB

Unique chunks Total chunks

Chunk index: 4 4

------------------------------------------------------------------------------Now we can see if it is realy there:

borg list --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.01_first_backup Sat, 2020-12-26 22:13:26 [e40e34c423ed1dba3ab1243840a3840b244f0f423f8bc96e50773879ae3184cd]And see what is in it:

borg list --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.::01_first_backupdrwxr-xr-x jlippmann 1728021072 0 Mon, 2020-12-21 07:48:10 files_to_back_up

-rw-r--r-- jlippmann 1728021072 11 Sat, 2020-12-26 22:04:13 files_to_back_up/zahlen.txt

-rw-r--r-- jlippmann 1728021072 27 Sat, 2020-12-26 22:04:13 files_to_back_up/buchstaben.txtchange some files and back up again

Now we add/change some files, create a new backup (without –stats this time) and check if it is there as well.

echo "ABCDEFGHIJKLMNOPQRSTUVWXYZ" >> files_to_back_up/buchstaben.txt # change a file

echo "gnu penguin chamaeleon" > files_to_back_up/animals.txt # add a new file

# new backup

borg create --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.::02_second_backup files_to_back_upList all the backups.

borg list --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.01_first_backup Sat, 2020-12-26 22:13:26 [e40e34c423ed1dba3ab1243840a3840b244f0f423f8bc96e50773879ae3184cd]

02_second_backup Sat, 2020-12-26 22:15:35 [7a9d60039583b5c01dbf50df4b3f11c7736f1f5701c8822cc80b97e90aa2d220]

Look into 02_second_backup.

borg list --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.::02_second_backupdrwxr-xr-x jlippmann 1728021072 0 Sat, 2020-12-26 22:15:33 files_to_back_up

-rw-r--r-- jlippmann 1728021072 11 Sat, 2020-12-26 22:04:13 files_to_back_up/zahlen.txt

-rw-r--r-- jlippmann 1728021072 54 Sat, 2020-12-26 22:15:33 files_to_back_up/buchstaben.txt

-rw-r--r-- jlippmann 1728021072 23 Sat, 2020-12-26 22:15:33 files_to_back_up/animals.txt

Looking at the size of the file buchstaben.txt we see that it has grown.

Restore from backup

Next we loose our precious directory by accident…

rm -rf files_to_back_up # Oh no!… and want to get an old version of it back.

borg extract --rsh "ssh -i key_backups_of_NUE-MAC-087_id_ed25519" borg@regulus.fritz.box:.::01_first_backupThe files are back, as expected.

ls -la files_to_back_uptotal 16

drwxr-xr-x 4 jlippmann 1728021072 128 21 Dez 07:48 .

drwxr-xr-x 12 jlippmann 1728021072 384 26 Dez 22:40 ..

-rw-r--r-- 1 jlippmann 1728021072 27 26 Dez 22:04 buchstaben.txt

-rw-r--r-- 1 jlippmann 1728021072 11 26 Dez 22:04 zahlen.txtfun errors

I am currently rewriting Chris Wellons’s racing simulation in rust as a training exercise. His program is really nice in that it is visual, interesting and well under 500 lines of Code - really inspiring. (I wouldn’t have minded speaking variable names and comments though).